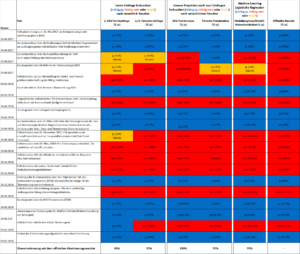

Prognosen und Resultate weiterer Modelle für die Abstimmungen vom 24. November 2024

Beschreibung der Modelle gemäss Poster

In der Tabelle unten sind die Modellwahrscheinlichkeiten für eine Annahme (blau) respektive Ablehnung (rot) angegeben:

Die meisten Modelle prognostizieren eine Annahme aller Vorlagen. Wie erwähnt, besteht ein Widerspruch zwischen dem Klassifikationsmodell und dem Regressionsmodell in Bezug auf die KVG-Revision (deshalb die Zweifarbigkeit).

Ablehnungen:Das tCNN erwartet eine Ablehnung des Bundesbeschlusses bezüglich des Ausbaus der Nationalstrassen und das LSTM erwartet eine Ablehnung der Änderung des Obligationenrechts (Mietrecht: Kündigung wegen Eigenbedarfs).

Gegenüberstellung der Machine Learning Modellprognose und den offiziellen Abstimmungsresultaten seit Mai 2017

Das Modell wurde Anfang 2017 erstellt und wurde seither nicht mehr angetastet. Die erste Prognose erfolgte für die Abstimmungen vom 21. 5. 2017. Bis und mit 22. September 2024 beträgt die Genauigkeit des Modells auf der Basis des Abstimmungsbüchleins 80.47 %. Siehe Tabelle unten.

Für die Gegenüberstellung der gewichteten Argumente aus dem Abstimmungsbüchlein wurde das hier beschriebene, validierte, getestete und für jedermann zugängliche online Modell eingesetzt, das auf regularisierter logistischer Regression basiert.

Modelle zur Textklassifikation sind ein klassisches Anwendungsgebiet von Machine Learning in der sogenannten „sentiment analysis“. Dabei werden typischerweise Restaurant oder Film Reviews auf ihre positive oder negative Wertigkeit klassifiziert. Dabei kann eine Beurteilung über den gesamten Text oder Teile davon erfolgen. Zum Beispiel „das Sushi war super, das Ramen war weniger gut“ dürfte als Ganzes eine mittelmässige Bewertung geben. Nur bezogen auf den ersten Satzteil würde ein trainiertes Modell eine positive Einschätzung der Bewertung abgeben, bezogen auf den zweiten Satzteil eine entsprechend negative.

Bei dem Modell zu Abstimmungsprognose handelt es um eine spezielle Anwendung der „sentiment analysis“.

Das vorliegende Modell liefert das „sentiment“ in Form einer Prognosewahrscheinlichkeit für ein «Ja» in einer möglichen Abstimmung. Diese Angabe kann (bezogen auf Textausschnitte aus dem Abstimmungsbüchlein) wie folgt interpretiert werden: welches Abstimmungsresultat wäre zu erwarten, wenn nur der gegebene Text vorliegen würde, oder: welches Gewicht hat der vorliegende Text gegenüber der Gewichtung des gesamten Textes?

In Zusammenhang mit den Abstimmungen vom 27. September 2020 erscheint interessant, dass sowohl die isoliert gewichteten Argumente der Gegner des Jagdgesetzes (das Referendumskomitee) eine (ungewollte) als auch diejenige der Befürworter eine positive Gewichtung haben. Trotzdem wurde gerade diese Vorlage abgelehnt. Eine mögliche Interpretation: eine Annahme des Jagdgesetzes wäre in der Kontinuität früherer Abstimmungen gelegen. Offenbar gab es Faktoren, welche mit dieser Kontinuität gebrochen haben, zum Beispiel ein engagierter Wahlkampf, oder andere Umstände (Corona-Pandemie?)

Beim Vaterschaftsurlaub fällt die Gewichtung der Argumente von Bundesrat und Parlament durch das Modell rein rechnerisch und unbeabsichtigt ablehnend aus.

Für die Gesamtprognose spielen die allgemeinen Informationen (die Ausgangslage) zur Vorlage sowie der Gesetzestext eine gewichtige Rolle und sie können die Argumente (mathematisch) in eine bestimmte Richtung umlenken oder verstärken (wie beim Erwerbsersatzgesetz oder der Vorlage zu den Kampfflugzeugen) oder verwässern (wie bei der Begrenzungsinitiative).

Bezogen auf die Abstimmungen vom 29. November 2020 und der Unternehmensverantwortungsinitiative spricht die Gewichtung der Argumente sowohl der Befürworter als auch der Gegner gegen die Vorlage.

Bei der Initiative gegen Kriegsmaterialproduzenten spricht (kongruenterweise) die isolierte Betrachtung der Argumente der Initianten für die Vorlage und diejenige der Gegner gegen Vorlage.

Gegenüberstellung von Abstimmungsprognosen basierend auf Umfragen zur Stimmabsicht und dem Machine Learning Modell

Die Tamedia Verlagsgruppe publiziert vor den eidgenössischen Abstimmungen jeweils zwei Berichte mit einer Zusammenfassung der Wahlumfragen der Schweizerischen Rundfunkgesellschaft (SRG) und Tamedia. Darin werden zwei Ansätze dargestellt, wie aufgrund der Umfragen zur Stimmabsicht eine Wahlprognose abgeleitet werden kann:

- die letzte (zweite) Umfrage wird mit dem tatsächlichen Abstimmungsergebnis verglichen

- aus zwei Umfragen wird durch lineare Extrapolation ein Trend abgeleitet, der mit dem tatsächlichen Abstimmungsergebnis verglichen wird

Hinweis: Ein Poster mit einem Vergleich aller vier entwickelter Machine Learning Modelle untereinander ist unter dem nächsten Register (weitere ML-Modelle) zu finden

Die hier abgebildete Tabelle stellt die Übereinstimmung dieser beiden Ansätze der herkömmlichen auf Umfragen gestützten Abstimmungsprognosen mit dem tatsächlichen Abstimmungsresultat dar. Dies ab der Abstimmung zur ‘Energiestrategie’ vom 21. Mai 2017. Zudem sind die Prognosen aus dem Machine Learning Modell (auf der Basis logistischer Regression) und dessen Übereinstimmung mit den Abstimmungsresultaten angegeben. Fehlprognosen sind ocker eingefärbt.

Resultate: Bezogen auf die letzten 19 eidgenössischen Abstimmungen beträgt die durchschnittliche Übereinstimmung der vier auf der Basis von Umfragen hergeleiteten Abstimmungsprognosen mit dem offiziellen Abstimmungsresultat 93 % (mit einer Streuung der Übereinstimmung je nach Methode zwischen 84 und 100 %). Das Machine Learning Modell LRM, das auf der Basis des Abstimmungsbüchleins hergeleitet wird, erreicht eine Übereinstimmung von 95 % mit den offiziellen Abstimmungsresultaten. Unabhängig von der Methode werden in etwa dieselben Prognosegenauigkeiten erzielt.

Diskussion und Schlussfolgerungen: Ein Machine Learning Modell basierend auf den Abstimmungsbüchlein der letzten 40 Jahre stellet eine interessante, kostengünstige, effiziente und verlässliche Ergänzung dar zur herkömmlichen Herleitung von Abstimmungsprognosen.

Angesichts der guten Verlässlichkeit und grossen Bedeutung von Abstimmungsumfragen im Rahmen der politischen Debatte und Meinungsbildung bleiben diese sicher unersetzbar.

Die Möglichkeit aufgrund des Abstimmungsbüchleins recht präzise Prognosen über den Ausgang der Abstimmungen abzugeben, wirft die Frage auf, ob über entsprechende Modelle die politische Debatte manipuliert werden könnte. Dazu sei gesagt, dass weiterhin gelten dürfte, dass die Debatte den Inhalt des Abstimmungsbüchleins definiert und nicht der Inhalt des Abstimmungsbüchleins die Debatte.

Hinweis: Die die Quelle (Tamedia) zu den hier verwendeten Umfrageresultaten beinhaltet keine Informationen zur Abstimmung über die ‘Finanzstrategie 2021’. Diese Daten wurden hier aus den entsprechenden Umfrageberichten von Tamedia und SRG hergeleitet und ergänzt.

Systematischer Vergleich von Machine Learning Modellen zur Vorhersage des Ausgangs von eidgenössischen Abstimmungen:

Ein Poster, vorgestellt an den Applied Machine Learning Days, January 26-29, 2019 (EPFL in Lausanne) vergleicht ein klassisches Modell auf der Basis logistischer Regression mit drei neuronalen Netzwerken.